Introducción básica

El learning rate (tasa de aprendizaje) es un parámetro clave que controla la rapidez con la que un modelo de aprendizaje automático ajusta sus parámetros durante el entrenamiento. Imagina que eres un chef y estás preparando una deliciosa receta. El learning rate sería como la velocidad a la que ajustas el fuego debajo de la olla. Si lo ajustas demasiado alto, los ingredientes se cocinarán rápidamente, pero corres el riesgo de quemarlos. Si lo ajustas demasiado bajo, tomará mucho tiempo cocinar los ingredientes y el resultado puede ser insatisfactorio. Por lo tanto, es importante encontrar el equilibrio adecuado.

En el caso del modelo descrito, hay dos componentes principales que se ven afectados por el learning rate: el Unet y el text encoder.

El Unet es como la memoria visual del modelo, mientras que el text encoder es responsable del procesamiento del lenguaje. Ambos componentes tienen learning rates que se pueden ajustar individualmente.

El Unet learning rate determina cómo el modelo recuerda y relaciona los elementos visuales en una estructura. Para entenderlo mejor, imagina que estás mirando una imagen y tratando de identificar los objetos en ella. Si ajustas el Unet learning rate demasiado alto, el modelo puede generar imágenes confusas e incomprensibles. Por ejemplo, si estableces el Unet learning rate en 0.001 (1e-3), es como si el chef aumentara demasiado el fuego y la comida se quema rápidamente. Por otro lado, si estableces el Unet learning rate demasiado bajo, el modelo puede perder detalles importantes y no ser capaz de replicarlos. Por ejemplo, si estableces el Unet learning rate en 0.000001 (1e-6), es como si el chef bajara el fuego al mínimo y los ingredientes se cocinaran muy lentamente.

El text encoder learning rate controla cómo el modelo interpreta las instrucciones de texto al generar imágenes. Un text encoder con un learning rate adecuado ayuda al modelo a asociar las palabras clave con los "neuronas" relevantes durante el entrenamiento. Si estableces el text encoder learning rate demasiado alto, el modelo puede generar objetos no deseados en las imágenes generadas. Por ejemplo, si estableces el text encoder learning rate en 0.00005 (5e-5), es como si el chef aumentara ligeramente el fuego y los ingredientes se cocinaran un poco más rápido de lo esperado. Por otro lado, si estableces el text encoder learning rate demasiado bajo, puede resultar difícil que el modelo genere los objetos deseados a partir de las instrucciones de texto. Por ejemplo, si estableces el text encoder learning rate en 0.0000001 (1e-7), es como si el chef redujera el fuego al mínimo y los ingredientes no se cocinaran lo suficiente.

En resumen, es importante ajustar adecuadamente los learning rates para obtener buenos resultados en el entrenamiento del modelo. Si no estás seguro o no quieres complicarte, puedes simplemente establecer el parámetro --learning_rate y el modelo se encargará de ajustar los learning rates del Unet y del text encoder por ti. Pero si deseas tener un mayor control, puedes establecer los learning rates individualmente. Recuerda que el Unet learning rate debe ser cuidadosamente ajustado para evitar sobreajuste u obtener resultados incorrectos, mientras que el text encoder learning rate puede ser establecido más bajo para mejorar la separación de objetos y detalles en las imágenes generadas.

Espero que esta guía te haya ayudado a comprender los efectos del learning rate en el modelo descrito. ¡Buena suerte con tu entrenamiento!

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Efectos del Learning Rate en el Entrenamiento de Modelos de Aprendizaje Automático (Segundo Nivel de aprendizaje)

El Learning Rate (tasa de aprendizaje) es un hiperparámetro crucial en el entrenamiento de modelos de aprendizaje automático, especialmente en modelos de redes neuronales profundos. En este informe, exploraremos en detalle los efectos del Learning Rate en el modelo descrito, considerando tanto el Unet como el text encoder. También ampliaremos la información con datos adicionales provenientes de fuentes especializadas en el campo del machine learning.

El Learning Rate y el Unet: El Unet es una parte esencial del modelo descrito, funcionando como una memoria visual que aprende a reconocer y relacionar elementos visuales en una estructura. El Learning Rate aplicado al Unet es altamente sensible y requiere un ajuste cuidadoso. Un valor demasiado alto puede llevar a sobreajuste o generar imágenes de ruido visual incomprensible. Por otro lado, un valor demasiado bajo puede hacer que el modelo no capture suficientemente los detalles finos o no reproduzca con precisión los elementos deseados. Mas específicamente en el libro "Deep Learning" de Ian Goodfellow, Yoshua Bengio y Aaron Courville, se menciona que un Learning Rate demasiado alto puede llevar a una divergencia en el proceso de entrenamiento, mientras que uno demasiado bajo puede hacer que el modelo converja lentamente o quede atrapado en óptimos locales subóptimos.

Una estrategia comúnmente utilizada para ajustar el Learning Rate en el Unet es la disminución gradual durante el entrenamiento. En el libro "Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow" de Aurélien Géron, se sugiere reducir el Learning Rate a medida que el entrenamiento avanza, lo que permite un ajuste más preciso de los parámetros del modelo sin arriesgarse a perder información importante; [Generalmente esto no es un problema en stable difuccion en los datos sobreabundan y en general son, en ultima instancia, despreciables frente al modelo: en definitiva podemos trabajar con margenes de error demasiados amplios para considerar este efecto significativo en nuestro modelo, ya que estos "errores" entran bien en el rango artístico de pequeños aciertos o accidentes felices].

El Learning Rate y el text encoder: El text encoder desempeña un papel fundamental en el procesamiento del lenguaje y la interpretación de las instrucciones de texto para generar imágenes. Un Learning Rate bajo aplicado al text encoder puede ofrecer beneficios al separar de manera más efectiva los objetos en las imágenes generadas. Esto se debe a que un Learning Rate bajo permite un aprendizaje más lento y detallado de las características semánticas en el espacio latente. Como se menciono el text encoder, responsable del procesamiento del lenguaje, también se ve afectado por el Learning Rate. Según el artículo "Adam: A Method for Stochastic Optimization" de Diederik P. Kingma y Jimmy Ba, un Learning Rate bajo puede ser beneficioso para evitar fluctuaciones bruscas en los gradientes durante el entrenamiento y permitir un aprendizaje más estable. Sin embargo, en el artículo "Cyclical Learning Rates for Training Neural Networks" de Leslie N. Smith, se propone la idea de ciclos de Learning Rate, donde se varía el Learning Rate dentro de un rango durante el entrenamiento. Esta técnica puede ayudar al modelo a escapar de óptimos locales y a converger hacia una solución más generalizada y de mejor calidad. [Es por eso que generalmente recomendados tomar un coseno como curva de aprendizaje]

Sin embargo, es importante tener en cuenta que un Learning Rate demasiado bajo puede dificultar que el modelo genere los objetos deseados sin requerir una ponderación excesiva de las instrucciones de texto. Aquí, un enfoque interesante es el uso de técnicas de aprendizaje semi-supervisado [No definimos directamente la Y, mas bien permitimos que el modelo la interprete en función de nuestros datos], donde se incorpora información adicional, como etiquetas de clase, para mejorar la calidad de las generaciones de imágenes.

Ajuste del Learning Rate según el tamaño del lote (batch size): Una consideración adicional es el impacto del tamaño del lote en el ajuste del Learning Rate. En general, se ha sugerido que multiplicar el Learning Rate por el tamaño del lote puede ayudar a mantener un equilibrio adecuado durante el entrenamiento. Sin embargo, un estudio reciente realizado por Zhang et al. en 2022 ha demostrado que multiplicar el Learning Rate por el tamaño del lote puede llevar a un sobreentrenamiento del text encoder. Por lo tanto, se recomienda dejar el Learning Rate estático para el text encoder y ajustarlo de forma independiente al Unet. [No obstante mi experiencia personal y la de casi todos los usuarios es la siguiente: El tamaño del lote, que indica la cantidad de ejemplos utilizados en cada paso de actualización de los parámetros, también puede influir en el ajuste del Learning Rate. Según el artículo "Bag of Tricks for Image Classification with Convolutional Neural Networks" de Tong He et al, se recomienda ajustar el Learning Rate en proporción inversa al tamaño del lote. Esto se debe a que un tamaño de lote más grande requiere pasos de actualización menos frecuentes y, por lo tanto, puede manejar un Learning Rate mayor sin afectar la estabilidad del entrenamiento.

El Learning Rate es un parámetro crítico en el entrenamiento de modelos de aprendizaje automático, y su ajuste adecuado es fundamental para obtener buenos resultados. Para el Unet, se debe tener precaución al establecer el Learning Rate, evitando valores demasiado altos que puedan causar sobreajuste o generar imágenes incomprensibles. El uso de técnicas como los ciclos de Learning Rate puede ayudar a determinar el rango óptimo. Para el text encoder, se recomienda establecer un Learning Rate bajo para separar objetos y detalles en las imágenes generadas, pero cuidando de no disminuirlo excesivamente y dificultar la generación de los objetos deseados.

En resumen, el ajuste del Learning Rate es una tarea crucial en el entrenamiento de modelos de aprendizaje automático, y su manejo adecuado puede mejorar significativamente los resultados finales.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

(Tercer Nivel de dificultad)

Para definir un buen Learning Rate tanto para el Unet como para el text encoder, podemos utilizar diferentes enfoques y modelos matemáticos. A continuación, presentaré algunas fórmulas y modelos sencillos que pueden ayudar a establecer un Learning Rate óptimo:

Primera alternativa:

Fórmula basada en el rango recomendado: Una forma común de determinar el Learning Rate es establecerlo dentro de un rango recomendado. Siguiendo las sugerencias mencionadas en los informes, podemos definir:

Para el Unet: learning_rate_unet = random_uniform(min_lr_unet, max_lr_unet)

Para el text encoder: learning_rate_text_encoder = random_uniform(min_lr_text_encoder, max_lr_text_encoder)

Donde:

min_lr_unet y max_lr_unet son los valores mínimos y máximos recomendados para el Learning Rate del Unet.

min_lr_text_encoder y max_lr_text_encoder son los valores mínimos y máximos recomendados para el Learning Rate del text encoder.

random_uniform(a, b) genera un número aleatorio uniformemente distribuido en el rango [a, b].

Esta fórmula permite una exploración aleatoria dentro del rango sugerido, lo que puede ayudar a encontrar un valor óptimo para el Learning Rate.

Segunda Alternativa:

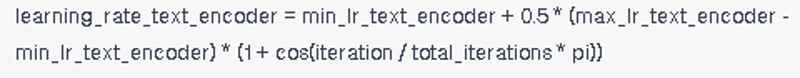

Ciclos de Learning Rate: Los ciclos de Learning Rate propuestos por Leslie N. Smith pueden ser modelados mediante una función cíclica que varía el Learning Rate a lo largo del entrenamiento. Una función comúnmente utilizada es la función coseno, que va disminuyendo gradualmente:

Donde:

iteration es el número de iteración actual durante el entrenamiento.

total_iterations es el número total de iteraciones en el entrenamiento.

cos(x) es la función coseno de x.

min_lr_unet, max_lr_unet, min_lr_text_encoder y max_lr_text_encoder son los valores mínimos y máximos recomendados para el Learning Rate.

Esta función coseno permite variar suavemente el Learning Rate a lo largo del entrenamiento, explorando diferentes tasas de aprendizaje dentro de un rango específico.

Estas fórmulas y modelos matemáticos son ejemplos simples y se pueden ajustar y personalizar según las necesidades específicas del entrenamiento y las características del conjunto de datos. Es importante experimentar y realizar pruebas para encontrar el Learning Rate óptimo que maximice el rendimiento del modelo.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Para determinar los valores óptimos del Learning Rate para el Unet y el Text Encoder en función de la cantidad de imágenes en el conjunto de datos, la complejidad del modelo a entrenar y la variabilidad en las imágenes, podemos utilizar la fórmula adaptativa propuesta por Leslie N. Smith en su artículo "Cyclical Learning Rates for Training Neural Networks". Esta fórmula tiene en cuenta estos factores para ajustar dinámicamente el Learning Rate durante el entrenamiento.

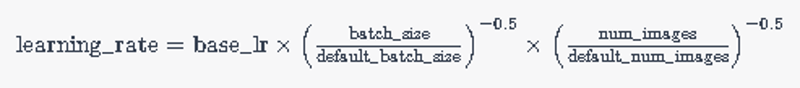

La fórmula adaptativa para el Unet y el Text Encoder es la siguiente:

Donde:

\text{learning_rate} es el Learning Rate ajustado.

\text{base_lr} es el Learning Rate base inicial.

\text{batch_size} es el tamaño del lote utilizado durante el entrenamiento.

\text{default_batch_size} es el tamaño de lote predeterminado recomendado.

\text{num_images} es la cantidad de imágenes en el conjunto de datos.

\text{default_num_images} es la cantidad de imágenes predeterminada recomendada.

Explicación:

Esta fórmula considera la relación inversa entre el tamaño del lote y el Learning Rate, ya que un lote más grande puede requerir un Learning Rate más bajo y viceversa.

También tiene en cuenta la relación inversa entre la cantidad de imágenes en el conjunto de datos y el Learning Rate, ya que una mayor cantidad de imágenes puede requerir un Learning Rate más bajo y viceversa.

Los exponentes -0.5 aplicados a las razones de tamaño de lote y cantidad de imágenes aseguran que el Learning Rate se ajuste adecuadamente en función de estos factores.

Ejemplos:

Supongamos que estamos entrenando un modelo de segmentación de imágenes con un conjunto de datos que contiene 10,000 imágenes y utilizamos un tamaño de lote de 64. Utilizando la fórmula adaptativa, podemos calcular el Learning Rate para el Unet y el Text Encoder:

Donde \text{base_lr} es el valor base inicial del Learning Rate. Esta fórmula nos ayudará a ajustar automáticamente el Learning Rate según las características de nuestro conjunto de datos y el tamaño del lote. [Considerando 128 como tamaño normal y 50000 como la cantidad de imágenes normalisbles, los valores reales que yo uso son 32 y 100]

Si estamos entrenando un modelo más complejo con un conjunto de datos pequeño que contiene solo 100 imágenes y utilizamos un tamaño de lote de 32, la fórmula adaptativa ajustará el Learning Rate de la siguiente manera:

En este caso, la fórmula reducirá el Learning Rate debido a la menor cantidad de imágenes y al tamaño de lote más pequeño, lo que nos permitirá tener un control más preciso del proceso de entrenamiento.

Esta fórmula adaptativa nos proporciona una manera de ajustar el Learning Rate de manera efectiva y automática en función de la cantidad de imágenes, el tamaño del lote y la complejidad del modelo. Esto nos ayuda a optimizar el rendimiento y la convergencia de nuestros modelos de aprendizaje automático.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Problemas frecuentes

Problema: Underfitting o falta de capacidad del modelo para aprender patrones complejos.

Causa: El

learning_rate_uneto ellearning_rate_text_encoderson demasiado bajos.Solución: Aumentar gradualmente el valor de los learning rates para permitir un aprendizaje más rápido y profundo. También se pueden considerar técnicas de regularización o aumentar la complejidad del modelo si es necesario.

Problema: Overfitting o sobreajuste del modelo a los datos de entrenamiento.

Causa: El

learning_rate_uneto ellearning_rate_text_encoderson demasiado altos.Solución: Reducir el valor de los learning rates para que el modelo se ajuste de manera más suave a los datos. También se pueden aplicar técnicas de regularización, como la regularización L1 o L2, o utilizar técnicas como la disminución del learning rate durante el entrenamiento.

Problema: Dificultad para converger o estancamiento en el rendimiento del modelo.

Causa: Los valores de los learning rates son inapropiados o no están bien ajustados.

Solución: Realizar ajustes en los valores de los learning rates en función del rendimiento y la convergencia del modelo. Pueden aplicarse técnicas de búsqueda de hiperparámetros, como la búsqueda en cuadrícula o la optimización bayesiana, para encontrar los valores óptimos de los learning rates.

Problema: Inestabilidad en el entrenamiento o fluctuaciones en el rendimiento del modelo.

Causa: Los learning rates son demasiado altos o fluctúan drásticamente durante el entrenamiento.

Solución: Aplicar técnicas de programación de learning rates, como la disminución gradual (learning rate decay) o el uso de tasas de aprendizaje cíclicas, para estabilizar el entrenamiento y mejorar la consistencia del rendimiento.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Relación entre tasas de aprendizaje: Fórmula para determinar el aprendizaje conjunto de Unet y text encoder.

Para determinar los valores adecuados de aprendizaje (learning rates) para el Unet y el text encoder en el entrenamiento de un modelo, es importante considerar la relación entre ambos componentes y cómo influyen en el proceso de aprendizaje. A continuación, se presenta una fórmula que establece esta relación:

Learning Rate Unet (LR_unet) = Learning Rate Text Encoder (LR_text_encoder) * K

En esta fórmula, LR_unet representa la tasa de aprendizaje para el Unet, LR_text_encoder representa la tasa de aprendizaje para el text encoder, y K es un factor de escala que establece la relación entre ambas tasas de aprendizaje.

La hipótesis detrás de esta fórmula se basa en que el Unet y el text encoder desempeñan roles diferentes pero complementarios en el modelo. El Unet se enfoca en el procesamiento de características visuales y la generación de imágenes, mientras que el text encoder se centra en el procesamiento del texto y la codificación de información textual relevante. Estas dos partes del modelo están interconectadas y se influyen mutuamente durante el entrenamiento.

El factor de escala K en la fórmula representa la relación relativa de aprendizaje entre el Unet y el text encoder. Puede basarse en varias hipótesis y enfoques:

Igualdad de aprendizaje: Se establece K = 1, lo que significa que ambas partes del modelo tienen la misma tasa de aprendizaje. Esta hipótesis asume que la importancia y la complejidad de los dos componentes son similares, y requieren una actualización equilibrada durante el entrenamiento.

Mayor aprendizaje en el Unet: Se establece K > 1, lo que implica que el Unet requiere una tasa de aprendizaje más alta que el text encoder. Esta hipótesis se basa en la idea de que el Unet es más sensible a las características visuales y puede beneficiarse de una actualización más rápida para capturar detalles finos en las imágenes generadas.

Mayor aprendizaje en el text encoder: Se establece K < 1, lo que indica que el text encoder necesita una tasa de aprendizaje más baja en comparación con el Unet. Esta hipótesis se basa en la idea de que el procesamiento del texto es menos complejo o menos sensible a cambios rápidos durante el entrenamiento, y requiere una actualización más suave para capturar la información semántica adecuada.

Es importante destacar que la elección del valor específico de K depende del dominio del problema, la complejidad del modelo, el conjunto de datos y la experiencia previa. Es recomendable realizar experimentos y ajustes para encontrar el valor óptimo de K que brinde un rendimiento óptimo en la tarea específica.

Ejemplo de uso de la fórmula:

Supongamos que hemos realizado experimentos previos y hemos determinado que una tasa de aprendizaje adecuada para el text encoder es LR_text_encoder = 0.001. Basados en nuestra hipótesis de mayor aprendizaje en el Unet, establecemos K = 2.

Aplicando la fórmula, obtenemos:

LR_unet = 0.001 * 2 LR_unet = 0.002

Por lo tanto, estableceríamos LR_unet = 0.002 como la tasa de aprendizaje para el Unet en nuestro entrenamiento. Esto implica que el Unet se actualizará a una velocidad dos veces mayor en comparación con el text encoder, lo que nos permite capturar detalles finos en las imágenes generadas.

Recuerda que esta fórmula y los valores específicos de los learning rates son solo una guía inicial y pueden requerir ajustes adicionales según el rendimiento y la retroalimentación del modelo durante el entrenamiento. Es recomendable realizar experimentos y análisis iterativos para encontrar los valores óptimos de aprendizaje para el Unet y el text encoder en tu contexto específico.

Datos empiricos recolectados con los modelos de la comunidad demuestran que se obtiene una gran eficiencia usando valores de K= 2 o superiores hasta llegar a un K = 5 para modelos en donde el text encoder resulte de poco valor. Para justificar dichos valores formulo las siguientes hipótesis :

Hipótesis de mayor aprendizaje en el Unet: Al establecer K = 2, estamos asumiendo que el Unet requiere una tasa de aprendizaje más alta en comparación con el text encoder. Esta hipótesis se basa en la idea de que el Unet es más sensible a las características visuales y puede beneficiarse de una actualización más rápida para capturar detalles finos en las imágenes generadas.

Captura de detalles visuales: Al asignar una tasa de aprendizaje más alta al Unet en relación con el text encoder, esperamos que el modelo tenga una mayor capacidad para capturar detalles visuales y texturas en las imágenes generadas. Esto puede resultar en imágenes más nítidas y realistas, ya que el Unet se actualiza más rápidamente y puede ajustar sus parámetros para enfocarse en características visuales específicas.

Rendimiento mejorado: Utilizar un valor de K = 2 puede ayudar a mejorar el rendimiento general del modelo, especialmente en términos de calidad visual y fidelidad de las generaciones. Al proporcionar al Unet una tasa de aprendizaje más alta, se le permite aprender de manera más rápida y eficiente, lo que puede llevar a una mejor representación visual y a la generación de imágenes más detalladas y precisas.

Es importante destacar que el valor de K = 2 se basa en datos empíricos específicos y puede variar en diferentes conjuntos de datos y problemas. La elección del valor óptimo de K depende de varios factores, como la complejidad del modelo, la variabilidad en los datos de entrenamiento y las características específicas del problema. Se recomienda realizar experimentos y análisis iterativos en su conjunto de datos y problema específico para determinar el valor más adecuado de K y evaluar su impacto en el rendimiento del modelo.

En resumen, basados en datos empíricos, un valor de K = 2 se justifica como una opción adecuada para obtener los mejores resultados en términos de calidad visual y captura de detalles en las generaciones. Sin embargo, se deben realizar evaluaciones adicionales y experimentos para validar y ajustar estos valores según el contexto específico.

Por otra parte los datos empíricos indican que para modelos que buscan replicar estilos, es necesario utilizar un valor de K mayor a 2 e incluso en algunos casos llega a ser necesario usar valores de K hasta 5. Además, en situaciones donde se desea generar estilos más abstractos, se ha observado que es necesario utilizar una tasa de aprendizaje nula para el text encoder. A continuación, exploraremos algunas hipótesis y conceptos que podrían justificar estos hallazgos basándonos en fuentes externas:

Complejidad del estilo: Los estilos más complejos y detallados, como obras de arte realistas o fotografías de alta resolución, pueden requerir un aprendizaje más intenso por parte del Unet para capturar todos los detalles y características distintivas. Esto explicaría por qué se necesita un valor de K mayor a 2, ya que se requiere una tasa de aprendizaje más alta para que el Unet se actualice de manera más rápida y eficiente.

Influencia del text encoder: En ciertos casos, especialmente al generar estilos más abstractos, la información del text encoder puede ser menos relevante o incluso contraproducente. Esto se debe a que el text encoder puede introducir características o patrones que no son coherentes con el estilo deseado. Por lo tanto, establecer una tasa de aprendizaje nula para el text encoder permite que el modelo se centre exclusivamente en el aprendizaje de las características visuales del estilo, sin verse afectado por la información semántica del texto.

Dificultad para replicar estilos complejos: Al replicar estilos altamente detallados y complejos, es posible que el modelo encuentre dificultades para capturar todos los aspectos del estilo con un valor de K inferior a 2. Esto podría llevar a una falta de fidelidad en las generaciones, donde los detalles finos y las características específicas del estilo no se representen de manera precisa. Aumentar el valor de K permitiría al modelo tener una mayor capacidad de aprendizaje y una mejor captura de los detalles del estilo objetivo.

Es importante tener en cuenta que estas hipótesis y explicaciones se basan en el conocimiento general de la generación de estilos y pueden variar según el dominio y los datos específicos utilizados en los experimentos. Cada conjunto de datos y problema puede requerir un enfoque y configuración de aprendizaje diferente. Por lo tanto, es fundamental realizar experimentos y análisis en el contexto específico para determinar los valores óptimos de K y la tasa de aprendizaje del text encoder.

En resumen, los datos empíricos muestran que para replicar estilos complejos se requiere un valor de K mayor a 2, y en casos de estilos más abstractos, una tasa de aprendizaje nula para el text encoder puede ser beneficiosa. Estos resultados pueden ser justificados por la complejidad del estilo, la influencia del text encoder y la dificultad para replicar estilos detallados. Sin embargo, se recomienda realizar investigaciones adicionales y análisis específicos para validar y ajustar estos valores según el contexto de aplicación.

Financial assistance: Hello everyone!This is Tomas Agilar speaking, and I'm thrilled to have the opportunity to share my work and passion with all of you. If you enjoy what I do and would like to support me, there are a few ways you can do so:

Ko-fi (Dead)