Type | |

Stats | 894 6,720 |

Reviews | (120) |

Published | Jul 11, 2023 |

Base Model | |

Hash | AutoV2 5CE2304773 |

请看看简介再下载(喵o(=•ェ•=)m)

Please take a look at the profile before downloading (喵 o(=•ェ•=)m)

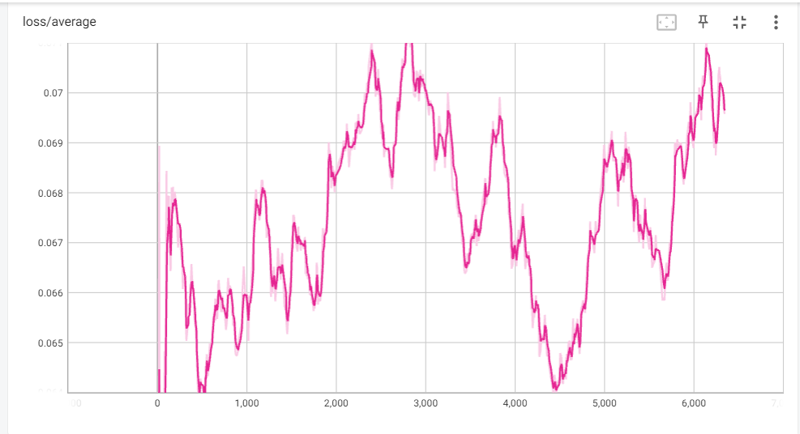

新更新:1.2版本降了3个epoch,可能会更好一点,不会那么过拟合(从9epoch变为6epoch)

New update: The 1.2 version has dropped 3 epochs, it may be better, and it will not be so overfitting (from 9epoch to 6epoch)

!!!记得搭配人物lora使用,这个画风模型目前能直出某些角色,但对于其他角色,要搭配lora才行,目前能直出的角色有(凯尔希,雷神,八重神子,甘雨,初音未来miku)是因为训练集里面经常出现这样角色,但为了达到较好的出图效果还是要配合人物lora使用的(比如示例图post里面的斯卡蒂,2b,闪电姐,都是搭配人物lora图生图i2i弄出来的)!!!

ps:line/conv alpha同时拉到1的效果太强了,可能需要多重epoch才会过拟合,而单单提升学习率可能没什么影响......(也可能是我提升学习率提的不够?)

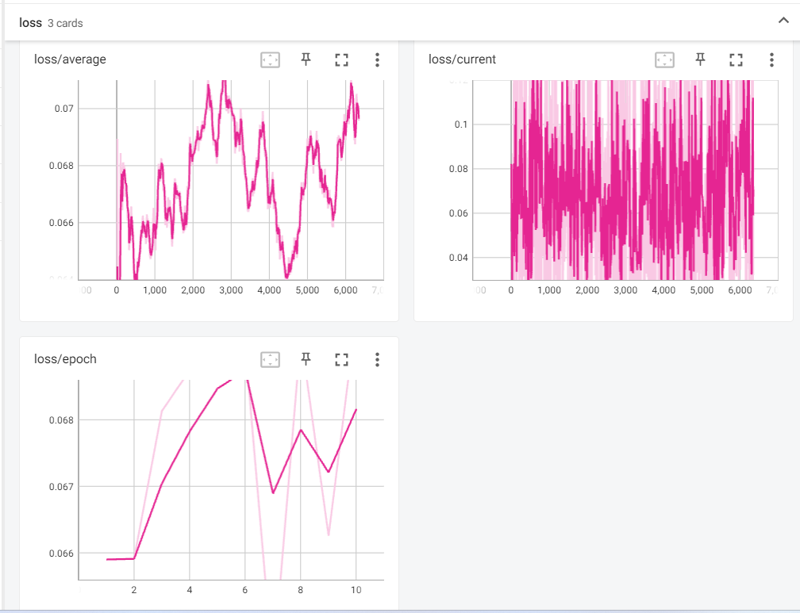

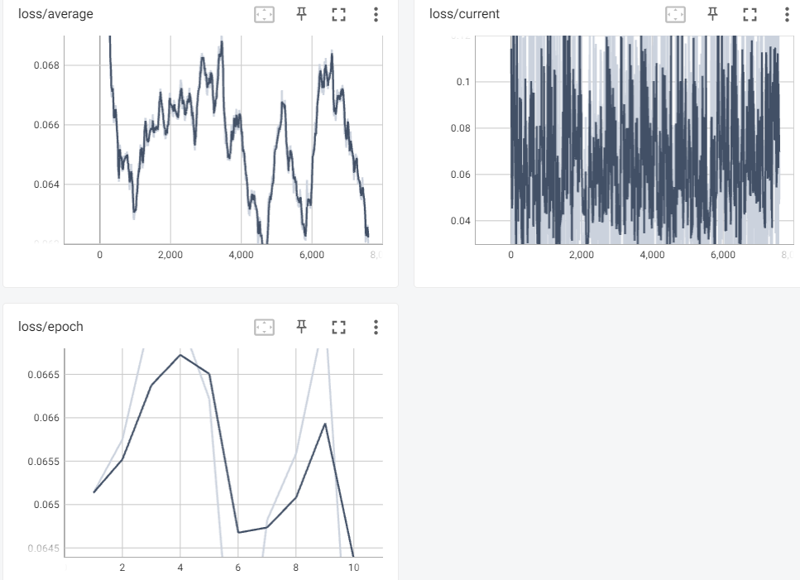

loss曲线一直在上升,感觉一直有进一步拟合的可能性(不会真的欠拟合吧.....艹了)

下一次可能会将训练集里的内容重新整合,只保留原图,不对原图进行切割///

(微微吐槽一下,autodl的网速是真的慢......我已经等了半个小时咧......他还没上传完.....

大家想自己炼丹的话还是买一个3090或者3090ti吧.....autodl实在是太慢了,只能用于小训练集

,训练集一旦到了几百张几千张图,单单是上传图片就要等上个把小时,就离谱好吧,问题是这玩意还是按小时收费的.......(感觉被ex到咧 :C ) )

(1.0/1.1)

loss值如下:

推荐权重0.8到1(?貌似直接用1也可以)

The recommended weight is 0.8 to 1 (? It seems that 1 can be used directly)

NAI final prune上训练,634张图片(包含部分剪裁后的图)训练参数如下

(1.0为5epoch,1.1为9epoch)

pretrained_model_name_or_path = "/root/autodl-tmp/lora-scripts/sd-models/model.ckpt" v2 = false train_data_dir = "/root/autodl-tmp/lora-scripts//train/AGM" resolution = "1280,1280" enable_bucket = true min_bucket_reso = 256 max_bucket_reso = 1_536 output_name = "AGM1" output_dir = "./output" save_model_as = "safetensors" save_every_n_epochs = 1 max_train_epochs = 10 train_batch_size = 2 network_train_unet_only = false network_train_text_encoder_only = false learning_rate = 0.00007 unet_lr = 0.00007 text_encoder_lr = 0.000008 lr_scheduler = "cosine_with_restarts" optimizer_type = "Lion" lr_scheduler_num_cycles = 3 network_module = "lycoris.kohya" network_dim = 16 network_alpha = 1 log_with = "tensorboard" logging_dir = "./logs" caption_extension = ".txt" shuffle_caption = true weighted_captions = false keep_tokens = 0 max_token_length = 255 seed = 1_337 prior_loss_weight = 1 min_snr_gamma = 5 multires_noise_iterations = 6 multires_noise_discount = 0.3 clip_skip = 2 gradient_checkpointing = false mixed_precision = "fp16" save_precision = "fp16" xformers = true lowram = false cache_latents = true cache_latents_to_disk = false persistent_data_loader_workers = true network_args = [ "conv_dim=4", "conv_alpha=1", "dropout=0", "algo=loha" ]

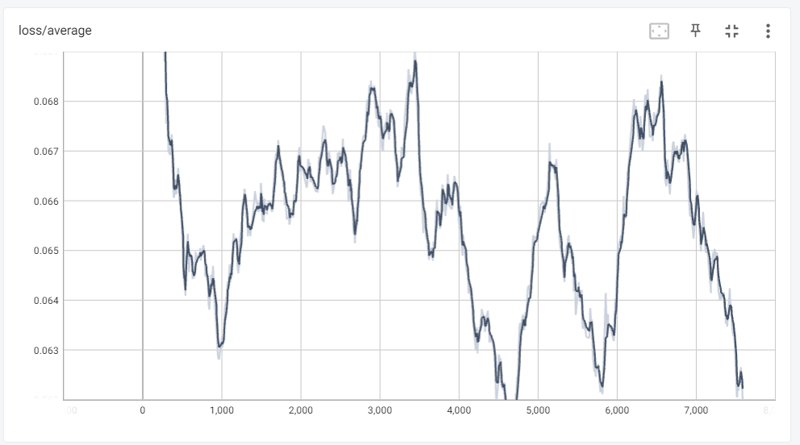

(1.2)

目前比较满意的一个loha模型,感觉挺还原的,同时不会太过拟合

推荐权重在0.7附近,我是用0.7到0.8这个区间

The recommended weight is around 0.7, and I use the range from 0.7 to 0.8

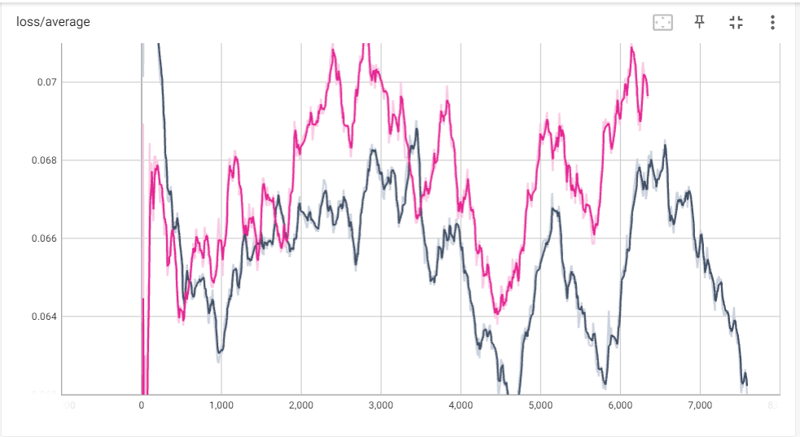

loss值对比

(1.0/1.1版本与1.2版本对比)

loss值明显比之前的两个版本低了不少,非常奈斯(笑)

训练参数如下

500张图,NAI上训练

batchsize2,repeat3

7e-5/7e-5/8e-6

润了润了

(v1.2.1)

删去了全部差分,并使用了line alpha为1来训练

相比于v1.2来说还原度在差不多的情况下大幅减少了肢体错误,画面模糊等等

一共181张图(可能有点欠拟合,但是又感觉还原的很好.....让人十分困惑)

推荐强度 1

(v1.3)

同1.2.1,改line alpha为line dim的1/2,因此相对来说拟合程度更高,肢体错误率更高,但画风更加贴近agm原型,

如果不是特别追求画风相近,可以用回v1.2.1,这样可以省下更多时间,而不用局部重绘修改错误之类的

(目前一直在寻求一种训练画风既可以拟合,又可以减少肢体错误的方法,目前来看修改训练集是首要的,其次是训练的参数,也就是te与unet的值和alpha的关系,目前还没有什么就比较好的头绪......感觉像是在碰运气.....)之后应该会沉寂一段时间.....