这是中文版的教程~

For English Guide: How to Train Your Anime LoRA with Just 1 Image—And No PC Needed!? | Civitai

🏯前言

你是否觉得炼丹又复杂又难?

喜欢的角色冷门到爆,没一点高质量同人图就炼不了丹?

我甚至是用的手机上C站,手机总不可能用来炼丹吧?

非也,非也!

我可以告诉你:只要设置得当,其实只需要 1-2 张高质量图片,没电脑也能炼丹!

我连一张高质量图片都没有,只是单纯想舔管人,能变一个出来吗?

我不管我不管我就是要看涩图

太长不看

这里正好有个省流版教程:

😏省 流 助 手

准备至少 15 张不同角度/不同姿势的图片。

(不对啊,你不是说只要 1-2 张图吗?)

(省流版里写不下。不过如果你真的只把1-2 张图片丢进丹炉,丹炉有十分甚至九分的可能性会爆炸,你的 LoRA 会变成一坨翔。 如果你真的想用 1-2 张图片来炼丹,请往下翻到3或者4)把图片全丢进你自己的丹炉,或者C站的在线LoRA训练器(云 上 丹 炉)!

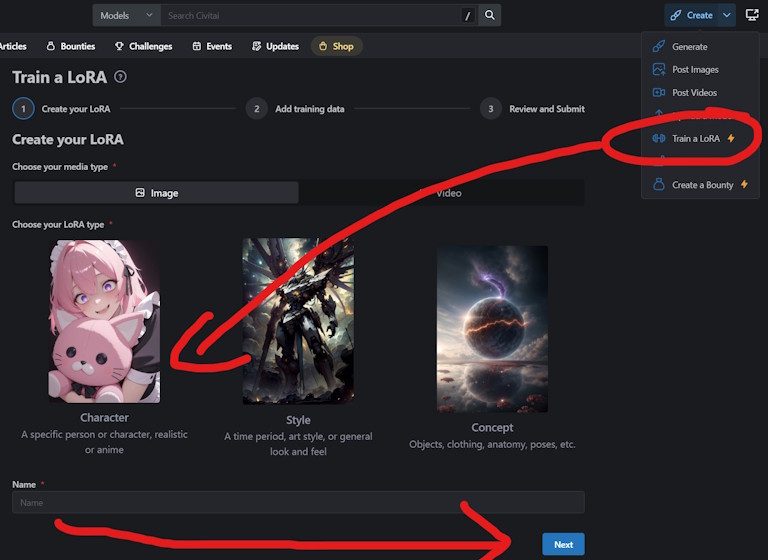

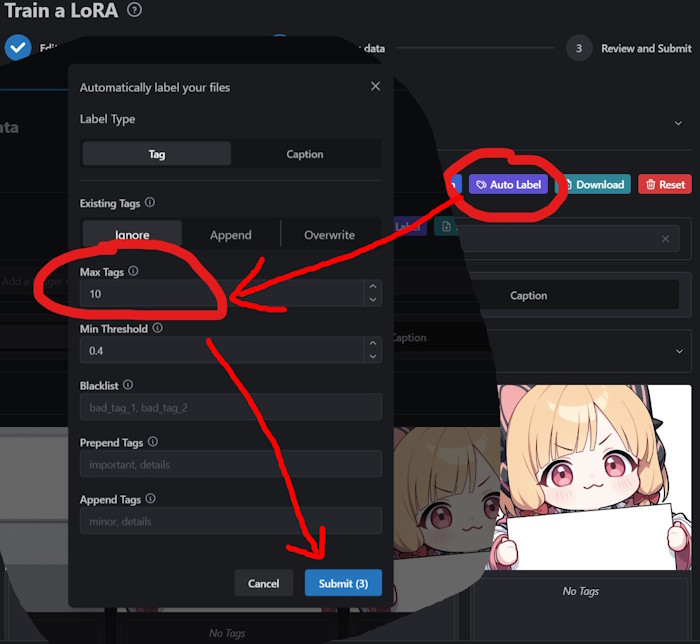

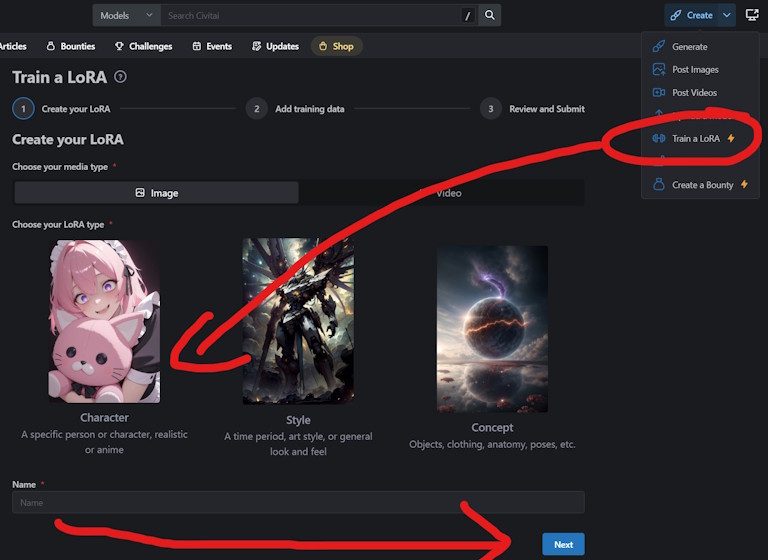

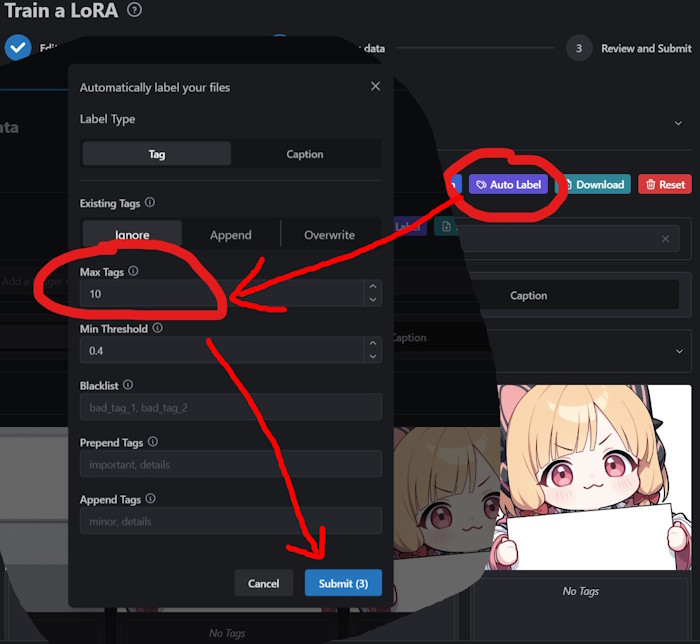

省流版优先说一下C站的丹炉,点“Auto Label”按钮。把 max tags 改成 20。然后点“submit”

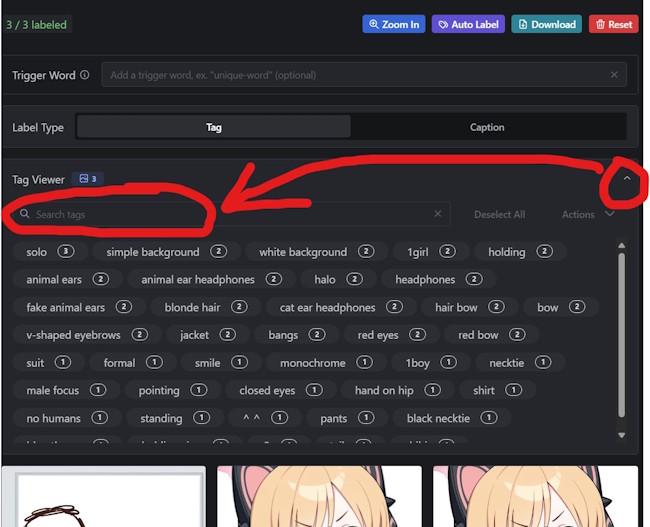

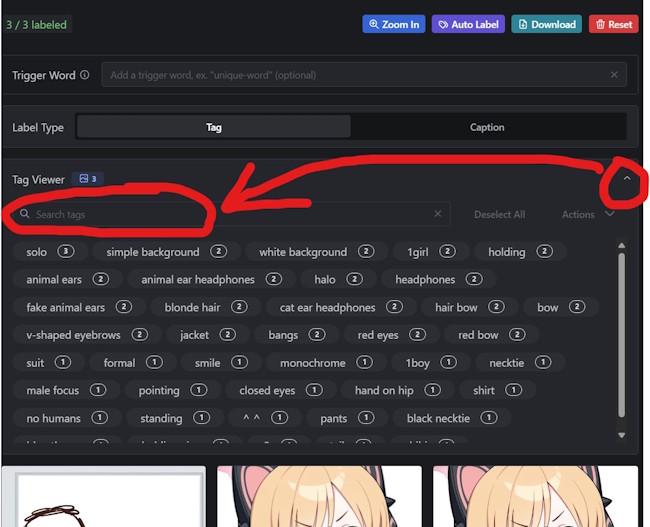

如果你在炼一个角色LoRA:筛选一下TAG:在Tag Viewer里输入 “hair” → 删除所有与你要炼的角色特征相关的标签,比如 blonde hair / long hair。同理,眼睛颜色(比如blue eyes等)也要删除。

但如果你在炼画风LoRA或者动作LoRA, 那么什么也不用删!

在上方的 "Trigger Word" 栏里添加一个独特,与众不同的触发词(例如 mikuBA / CaptainCiv / IamNailong)。然后点“Next”。

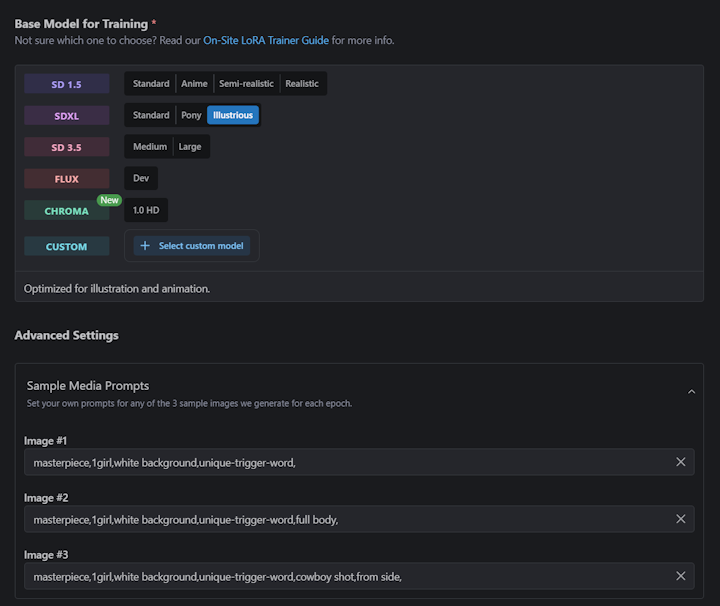

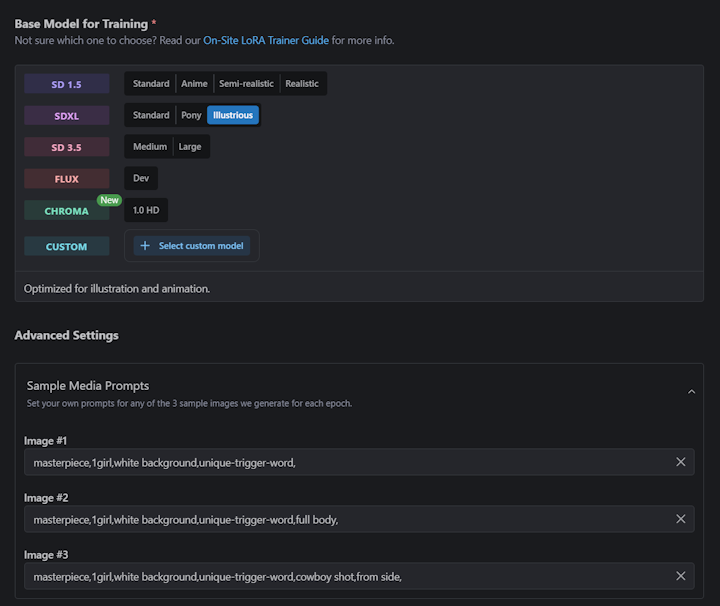

下一步:选择 Illustrious,这是目前开源模型里最常用的二次元风格模型了。

在Sample Media Prompts里填好提示词

举例:masterpiece,1girl,white background,[你的触发词]

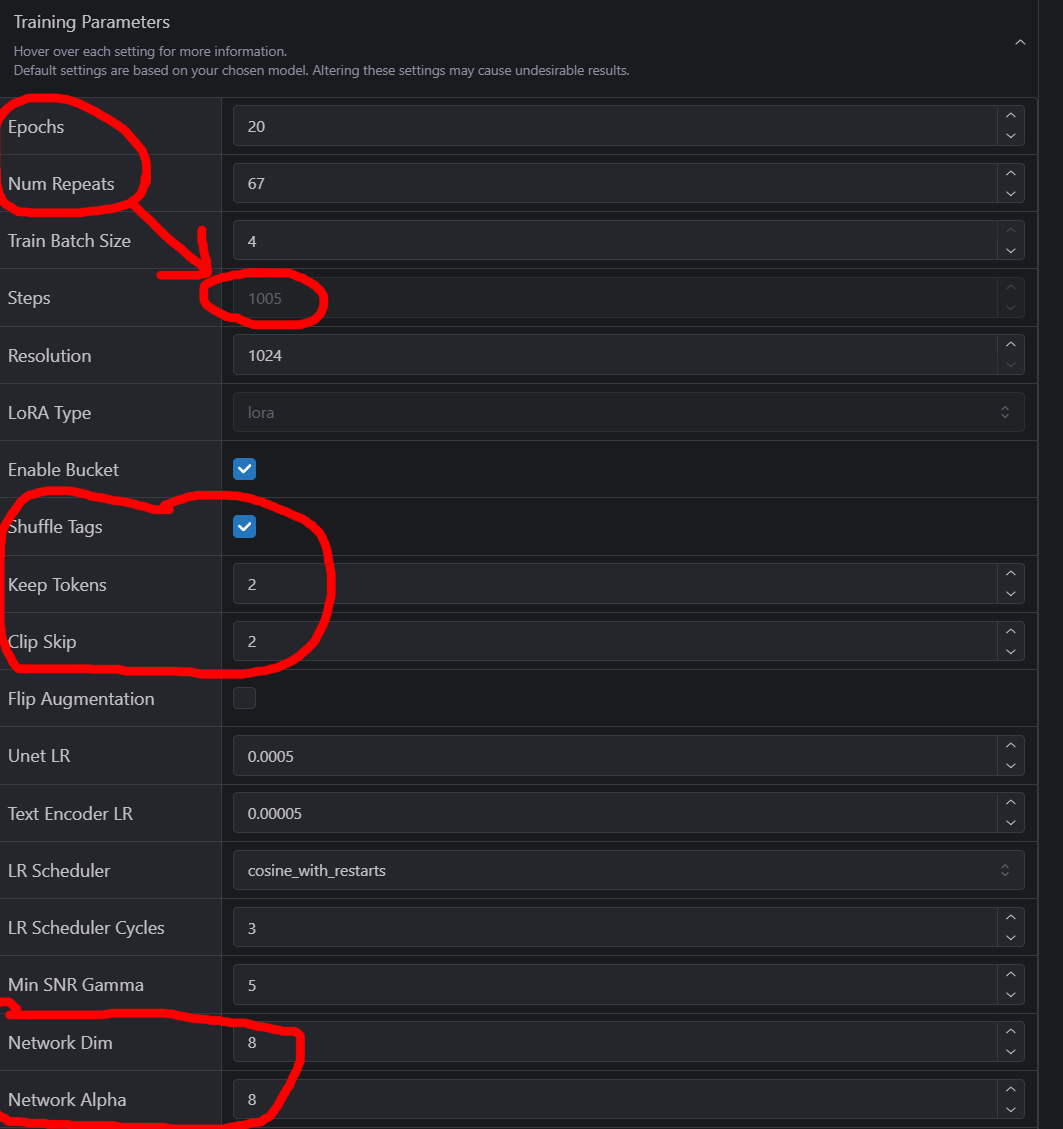

(如果你自己有电脑可以用来测试LoRA质量,那么可以跳过这一步。但是如果跳过了这一步,预览图会变成不可名状之物,不太利于你的SAN值。虽然由于预览图的Step只有10所以质量依然会是一坨,但是有至少比没有强……)在Training Parameters里调整参数。

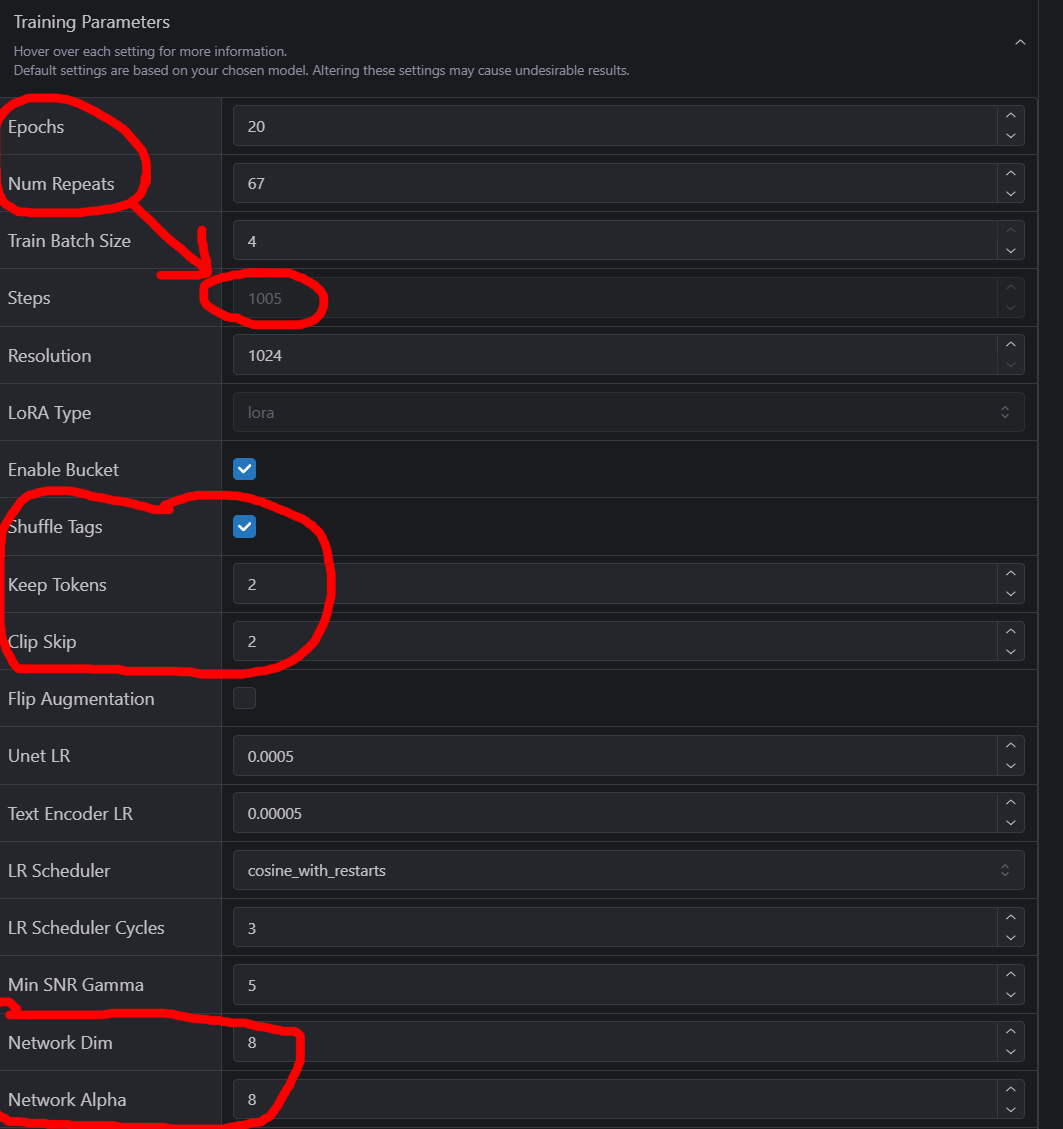

调整 "Epoch", "Num Repeats"。两个参数配合调整,让总训练步数(Steps)接近 1000。

(epoch 建议 15~20 起步。但 Num repeats 不要照抄我的例子,因为我这个例图里只有 3 张图,所以才写了 "67",一般情况 Num repeats 会更低。)把 "Clip Skip" 调成 2。

启用 "Shuffle tags",并设置 "keep tokens" 为 2。

把 "Network Dim/Alpha" 改为 8 甚至4(更加激进一点),可以让文件更小。

都设置好了就能点Submit开始了。会消耗500Buzz.

等上40-70分钟,炼丹进行时。

测试你的 LoRA Epoch,推荐从 50% 开始(比如 10/20 或 8/16)。

(测试需要有一台能跑SD的电脑,或者如果你订阅了C站会员则可以用C站的私密模式来测试。都没有就只能靠C站提供的预览图和运气了……碰运气的话推荐从75%开始)实际测试时如果看起来 欠拟合(缺少角色特征) → 往后多试 3 个 epoch(10 → 13 → 16)。

如果看起来 过拟合(姿势重复、奇怪的色块) → 往前一两个试试更早的 epoch。

测试好了?好,把他们上市!🎉

(但我炼出来的丹要么欠拟合要么过拟合,是垃圾中的战斗圾……

(那就扩大你的数据集!把之前失败 LoRA 中表现最好的图片挑出来,加进去,再用这个扩充过的数据集重新训练。不过如果你用的是C站的丹炉,那又得耗500buzz,是3天的每日获取量了……)

1. 为什么选择 Civitai 在线 LoRA 训练器?

因为它善。因为真的挺方便的!

C站丹炉底层其实就是 kohya-ss,所以和本地训练相比,并不会丢失质量或兼容性。

而且参数比本地 kohya 少得多,不会在命令行或一大堆设置里迷路。

对比一下:

本地训练(我用的4060 Ti ) → 训练一个 LoRA 至少要 1.5 小时。

在这段时间里,GPU 相关的工作(比如打游戏、生图)都完全不能用,只能刷刷网页用用微信之类的。

而且,显卡风扇会狂转,大晚上不太友好。Civitai 在线训练 → 同样的工作通常只需 40–60 分钟。训练时,你的电脑完全可以干别的事。

缺点:

C站在线训练器无法使用正则法!!!

这意味着如果你想训练《星期一的丰满》这种原图几乎都是蓝白,或者是黑白本子的角色的话,超大概率会翻车。正则法是解决这些问题的最佳方案。

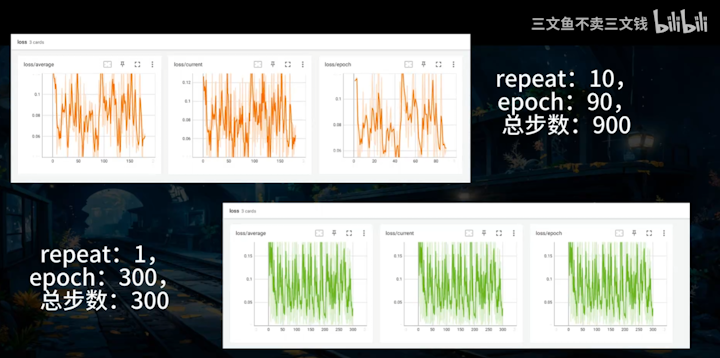

Civitai 的 LoRA 训练器没有 loss/average 曲线图,看不到每个 epoch 的 loss 变化。高手(不是我 😅)能用这些数据来更高效地判断最佳 epoch,但在线训练用户就没办法。

(偷一下三文鱼大佬的介绍视频的图)

3. 另外,在线训练器不支持训练 LyCORIS 类型模型。

我相信很多大佬土豪是可以将进行本地训练的。参数基本类似,只要找到和C站在线丹炉相同的参数,把数值改成对应的,效果是一样的。

2. 如何只用 1 张图训练 LoRA

主要是一些冷门二游角色,几乎没有同人图。

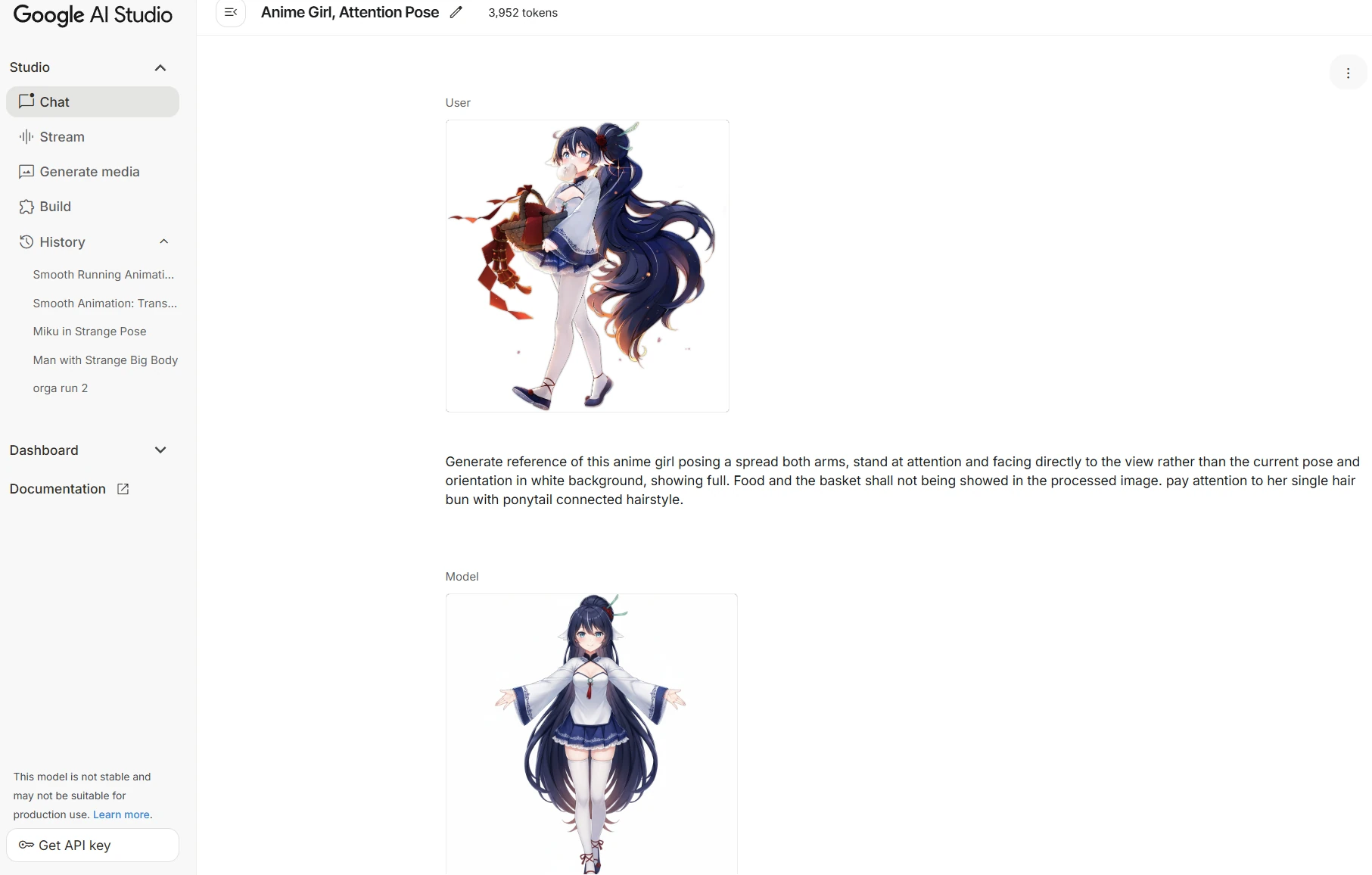

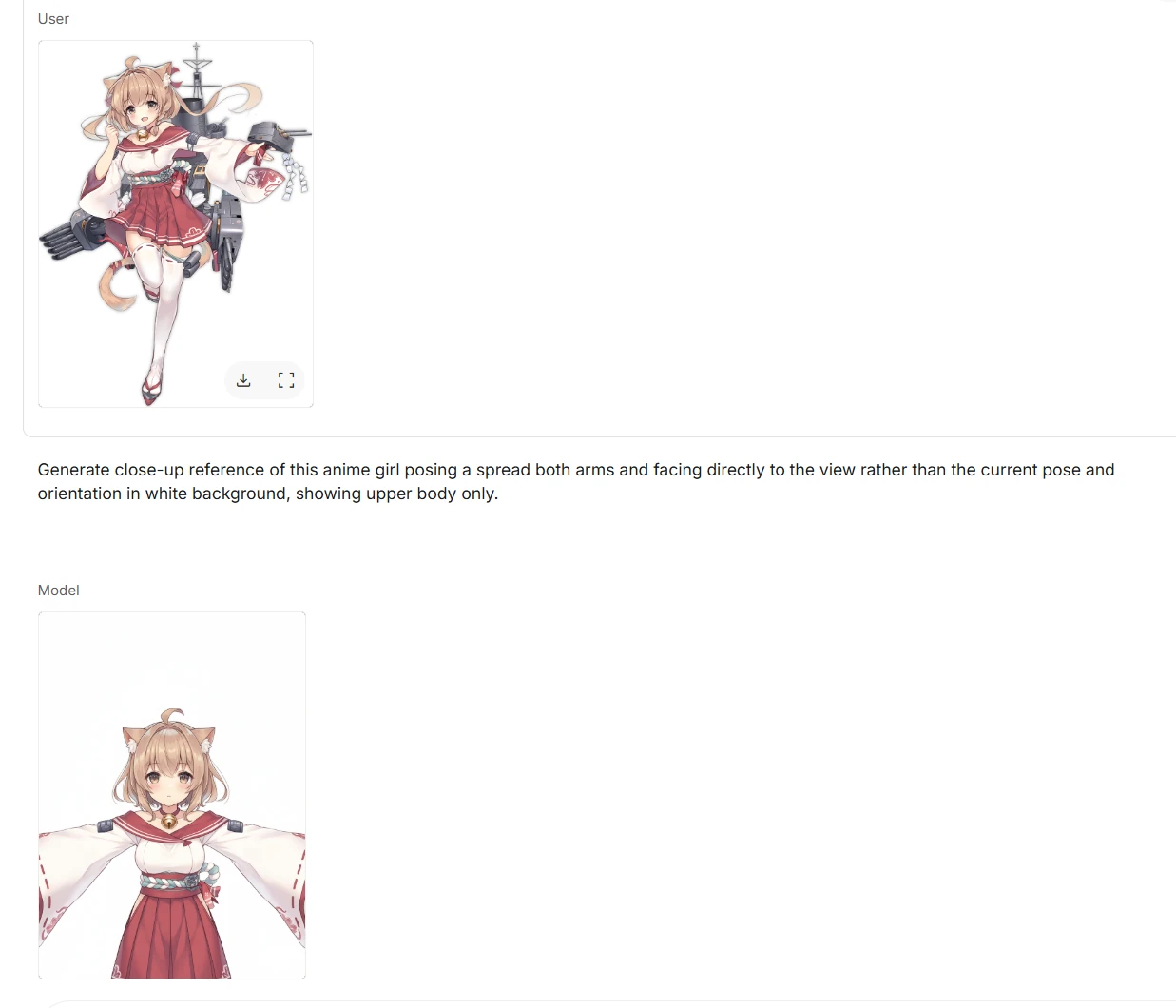

而且她们的布料往往不太多,你没法用谷歌大香蕉生成三视图(比如下面水无濑的例子,大香蕉会直接拒绝请求ORZ)

(如果她们布料还算正常,那么可以通过谷歌大香蕉(https://aistudio.google.com/)生成她们的各种姿势/角度,我们会在下面一个章节进一步讲。)

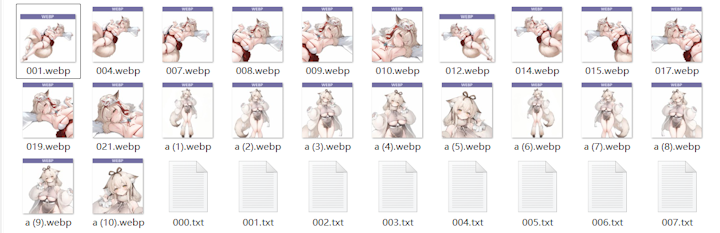

但1 张图其实可以变成 4–10 张独特的训练图!

奥义:裁剪+翻转!

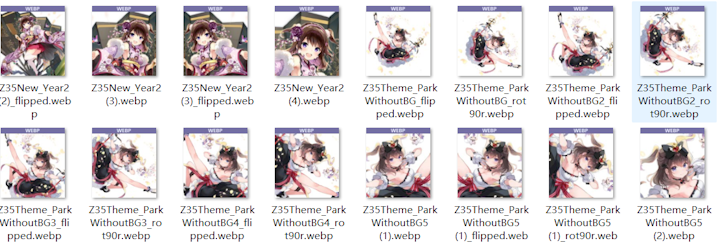

示例:我的水无濑LoRA

只用 2 张图训练完成。(1 张图也能用同样的方法。)

取 1 张原始图。

把它裁剪成多个子图:

全身

半身(cowboy shot)

上半身

头像

头像小图(avatar)

仅下半身

1 张图就能变成 6 张可用的训练样本。

(通常来说第一轮训练结果都很烂。从烂的图里面尽可能史里淘金,修一下图,然后把修好的图加到训练集里,进行第二轮,甚至第三轮训练,左脚踩右脚上天。)

⚠️ 注意:裁剪后的图,尤其是“仅下半身”的图,打标时得额外留个心眼,这样 LoRA 才能学到正确的特征。通常 WD1.4 能自动处理得不错,但最好瞄一眼。

我自己为了质量,都是手动裁(用的 Paint.NET)。

缺点:很费劲,而且没有批量处理支持。

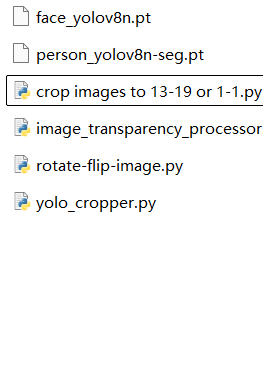

以前 HuggingFace 有一个在线角色裁剪项目,但已经寄了orz

想要批量裁剪 → 需要用 Ultralytics + Face/Body YOLOv8 预训练模型 + Pillow 写脚本(对新手不友好,但功能很强)。

超分放大

如果你的原图很小(比如只有300x300):

直接丢进丹炉,Kohya-ss 会用 Pillow 自动放大到 1024 → 结果会是一堆伪影,你的 LoRA 还会把伪影学进去并复现出来奇怪的色块。

解决办法:在训练前进行超分放大。

推荐:Remacri 或 RealESRGAN 4x Anime 6B。

这两个超分模型都不需要很好的显卡,CPU也能干(会慢一点)。甚至手机都能通过在线网站(比如waifu2x)上来超分

我个人更喜欢 Remacri → 因为它能保留更多原始细节。

缺点:同时也会把更多伪影保留下来。

我的做法:把超分好了的图再丢进 Stable Diffusion 的 i2i 或 inpaint,用低噪声修复 → 去掉伪影,同时尽量保持和原图一致。(这个手机真干不了了ORZ)

据说 CivitAI 在线生成器的标准 Hi-res Fix 用的就是 Remacri,但不确定。

如果你的原图很大,即便是裁剪后的角色头像,也能接近、等于甚至超过 1024px。

NB!可以直接跳过超分这一步了。

翻转

把每张裁剪图左右翻转。

这一步其实C站的丹炉本身就可以做(叫“Flip augmentation",点了之后你的图会随机左右翻转)

问题是不可控,只有1张图的极限情况下我个人会选择【不对称的地方不明显】的图进行翻转,而其他图保持原样。

翻转不适合非对称角色(例如只有一侧的饰品)。

比如我的白凤LoRA

角色头发只有一侧有发饰。

翻转后 AI 会误以为发饰两边都可能出现。我只好用 Paint.NET + SD Inpaint 手动修复(巨TM麻烦)。

即便这样,有时发饰还是会出现在错误的那边…… orz。

旋转 90° 左/右

在部分情况下可用,但要谨慎使用。

如果旋转后的姿势依然自然、不违和,那就没问题。

如果姿态看起来奇怪或不自然,AI 可能会混淆,反而拉低效果。我在做 Z35的 LoRA 时,只选择了那些旋转后看起来还算正常的图片进行 90° 旋转。

为什么裁剪 & 翻转有用?

强迫 AI 把身体部位分开学习,而不是只看一张完整图。

每次裁剪都会改变像素层级的数据,让训练不那么重复。

降低过拟合风险。

(Q:可我生成的角色老是摆同一个姿势啊!明显过拟合了!)

(A:裁剪和翻转总的来说只是应急。如果你想要更加好用的LoRA,还是只能扩大训练集)

⚠️ 总的来说:

这俩方式只能减少过拟合,不能完全消除。

因为所有图片都来自同一个姿势,所以 LoRA 还是更容易默认回那个姿势。

效果不如拥有真正多样化姿势的数据集。

但就算你的初始 LoRA 因为过拟合而卡在同一个姿势里,依然还有希望!

你可以大力出奇迹,先尽可能生成大量不同姿势和角度的图(即使大多数质量可能不太行)。然后,精挑细选那些与基础姿势差异够大的高质量图,把它们加入数据集。

这样就能从 1 张图变成无限张图了!

那代价是什么?更多的时间、精力,还有buzz……

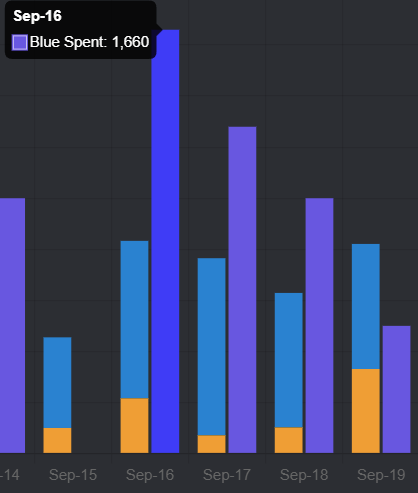

顺带提一嘴C站的Buzz :每天只要花不到 10 分钟,完成日常任务并参加每日挑战,就能赚到至少 400 蓝 buzz。如果你懂基础的AHK,甚至可以让AI写个脚本,用AHK每天全自动薅蓝BUZZ,完全解放双手

3. 一般情况下,你会有更多选择

大多数时候,你会有不止 2 张图。

更多的选择通常意味着 更好的 LoRA 质量,以及更轻松的工作流程。

但要记住:质量 > 数量

👉 20 张精挑细选的高质量图片,永远比 100 张模糊截图或崩坏的作画强。

可以把难度分级理解成这样:

简单模式:常见的番剧角色(比如每个季度都有的异世界厕纸)。

中等:带标准 3D 模型的二游角色(米游、鸣潮等)。

中等:热门 2D 二游角色,有大量同人图(如 FGO)。

困难:冷门的 2D 二戏角色——几乎没有好同人图,只能裁剪+翻转了。

图片主要来源

1. Google Nano Banana (谷歌大香蕉)

Nano Banana可以生成你老婆的完整参考图(reference sheet),包含多个角度——正面、侧面、背面。提示词可以照着我的图片抄。

但Nano Banana 也有不少缺点:

和谐:只要太暴露,Nano Banana 会自动给你加衣服。R沟?加上。下乳?加上。比基尼妹子?❌ “请求拒绝。”可惜了。

细节丢失:除非你运气爆棚,不然很多细节都会丢失,比如发饰、小首饰、身体饰品,你得在提示词里特别强调才行。但有时候即使强调了,Nano Banana 还是摆烂不画。

分辨率问题:输出图常常带一堆伪影。我强烈建议用 3.1 里提到的工具来放大和清理。

👉 总评:如果你的图池太小,Nano Banana 是个不错的副手,可以帮你补充数据集的多样性(前提是你角色别太暴露 xD)。

2. 动画截图

只选高质量画面(干净、清晰、无动态模糊、无作画崩坏)。

手动截图很枯燥。

如果你懒,可以用 YOLO 模型自动检测,但要一定编程/脚本能力。

3. 游戏截图

从多角度截图角色:

正面 ×3

两侧 ×3

背面 ×1

注意调整镜头(上半身、头像、全身)。

注意:即便画风是二次元,本质上还是 3D,这会影响训练。

如果你想要更“纯粹”的 二次元风格,可以在 Stable Diffusion 的 img2img 里加 ~0.3–0.4 噪声,把半 3D 渲染转成正常二次元风格。

4. Danbooru

AI界的基石,非常稳的选择,自带标签和筛选功能,更容易挑高质量同人图。

比 Pixiv 的垃圾内容少很多。

禁止 AI 生成内容,纯净度更高。

5. Pixiv

资源丰富,画师数量庞大。

但要小心:如今充斥着 AI 生成图。

AI 图虽然能用来喂,但通常会忽略细节——衣服纹理、饰品、独特特征可能缺失或错误。

如果过多使用这些图,你的 LoRA 也会无视关键细节(除非你对小细节不在乎)。

6. 裁剪 & 翻转(参考 3.1)

裁剪+翻转依然能保持和原画师风格的一致性。

对小数据集尤其重要。

4. 打标(tagging)

这步相对来说比较简单。但也看情况。

虽然简单,但打标也很重要。好在有 wd1.4 自动打标,其实对新手也很友好。

有两种方案:

在本地运行

用C站内置的自动打标器(同样基于 wd1.4)

本教程里我会用C站打标器,因为更直观(不过我自己是先在本地打,再用 BooruDatasetTagManager后处理)。

步骤

上传图片。

点 Auto-Label 。

点 Submit 。

稍等片刻就自动打好标了。

删除标签(针对角色LoRA)

如果你正在炼角色LoRA

在筛选栏输入 “hair”。

删除所有 发色 和 发长 标签(如 blue hair, long hair, short hair)。

⚠️ 像 hair ornament 或 hair flower 这种别删,除非它就是角色最重要的特征之一,比如《蔚蓝档案》里阿罗纳的白头巾最好一起删掉。

关于衣服,如果角色只有一套衣服一套发型(比如某星核精),那么你也可以考虑删掉衣服和发型TAG。

但如果有2套或以上的衣服,由于WD1.4对服装打标没发色和瞳色那么准确,删掉衣服标签可能反而会让你更加难以通过触发词还原这些换装,这种情况下个人并不推荐删掉这些TAG!

切换筛选到 “eye”。

同样删除颜色标签(如 yellow eyes, green eyes)。

大致看一下整个标签列表,删除:

其他独特的角色特征(如 ahoge、cat ears、animal ears、tails)。

错误的标签,比如:

无关的随机标签(如 “virtual YouTubers”,而你其实并不是在训练管人)。

错误的服装颜色(比如 “pink kimono”,实际上角色穿的是紫色)。

这样可以确保 LoRA 学到的是准确特征,避免把错误信息写死到模型里。

如果你在炼画风LORA或者动作LORA,那么不需要删除任何标签。打标打完了就可以加触发词,直接区下一步了。

添加触发词

在上方的 Trigger Word 栏输入一个独特触发词。

(例如:mikuBA / CaptainCiv / 总之是个独特的词)

触发词就像召唤阵,把那些被删掉的特征凝聚成一个咒语。

不再分散在标签里,而是压缩成一个“咒语”,迫使LoRA在生成时准确召回角色的核心特征。

5. 训练设置

倒数第二步了!打完标签点下 Next,就是LoRA 诞生前的关键步骤页面了。

🏯 模型选择

光辉系的LoRA 建议直接用 IllustriousXL v0.1 (就是最上面那个默认的)。

光辉系的基石。

训练程度相对较低,反而留给你更大的灵活性。

NoobAI 模型(包括 V预测)同样能用。

消耗比自定义基底便宜:IllustriousXL v0.1 只需 500 buzz,而 WAI-ILL 之类的定制底模至少要 1000 buzz 💸。

当然,你也能选 Pony 或 SDXL,但 Illustrious 更适合二次元(代价是写实能力一坨)。

🖼️ 预览图(Sample Media Prompts)

如果你自己有能跑SD的电脑,或者订阅了C站会员,那这步其实是可以跳过的。不过为了你的身心健康我建议你填一下……如果什么都不填,C站会给你生成一堆克苏鲁,非常恐怖

⚠️ 注意C站的预览图只跑 10个Steps,所以预览图画质基本上惨不忍睹。

但这还不是最惨的,最惨的是当你步满足以下条件:

有本地电脑能跑 SD来实操预览

订阅了C站会员能用隐私模式来预览

……那么这破预览图还真就是你唯一能用来参考质量的途径了。

推荐的 3 条 prompt:

masterpiece, 1girl, solo, white background, [你的触发词],masterpiece, 1girl, solo, white background, [你的触发词], full body,masterpiece, 1girl, solo, white background, [你的触发词], from side, cowboy shot,👉 实际训练过程中右键新标签页打开预览图,可以更方便比对。

🔧 训练参数

C站已经简化了很多,只剩几个关键项:

必须改的:

Num repeats & epochs(决定总步数)

Clip skip

Network DIM

Network Alpha

Shuffle prompts

Clip Skip

动漫设 clip skip = 2。

CLIP 有 12 层,默认取最后一层。

动漫数据更适合倒数第二层。

Network Dim & Alpha

推荐:

DIM = 8 → 文件 ≈ 54 MB(稳健的选择,平衡)

或 DIM = 4 → 文件 ≈ 27 MB(激进一点,我个人常用)

Alpha = DIM 或 DIM/2(我更倾向于和 DIM 相等)

不建议默认 32,二次元LoRA用不了那么多。参考下图。

写实 LoRA 才会要更高 DIM。

Shuffle tags & Keep tokens

Shuffle tags那个选项打勾

Keep tokens = 2

保证你的触发词被锁定在首位,同时打乱其他标签增加变化。

训练步数

Steps = (图片数 × Epochs × Repeats) ÷ Batch size默认 Batch size = 4 ,不用改(又快又稳)。

目标:~1000 steps

其实750步也能出不错的结果,1000保险一点

2000–3000 steps 几乎必过拟合(除非你有 200+ 图)

C站超过 1050 steps 就要额外收 buzz,Steps越多收的越多

Epochs 和 Repeats的关系

理论上对小数据集来说,高 repeats × 低 epochs更好,因为能设置部分图的权重。问题是C站并不能设权重。

所以建议 Epochs 稍微高点。

👉 个人常用:

Epochs = 16–20

调整 Repeats,让 Steps ≈ 1000

这样训练到 50–70% 时(例:16个epoch 的话就是第 11~12 个,18个epoch 的话就是第 12~13 个)可能就有合适的Epoch能用了。

我个人会隔 3~4 epoch 测一次(例:10 → 13 → 16 → 19),方便看过拟合的迹象。

测试不同的 epoch 通常需要一台本地电脑。

但如果你没有本地电脑、但是订阅了C站会员,那C站的隐私模式也是能测试的。

🌀 LyCORIS(进阶,本地专用)

如果你在自己的本地电脑训练,那不一定要炼LoRA,还可以在 Network Module 里选择 LyCORIS。

LyCORIS 使用 LoKR 算法(在 “LyCORIS algo” 选项中选择)。

对比标准 LoRA,它在以下方面表现更好:

画风训练

单模型处理多角色

⚠️ 注意:LyCORIS的参数与 LoRA 完全不同:

需要设一个超大的 DIM(比如 114514)

Alpha=1就行

LoKR factor 推荐 8(数字越小占用 VRAM 越多,输出文件越大)

我没训练过,但根据今宵佬:

LoKR factor = 4,Batch size = 2 → 训练就已经用掉 13 GB VRAM

其他参数(epochs、repeats、shuffle prompts 等)与 LoRA 类似。

由于本指南重点是 LoRA,这里先简单带过。

但如果你想做高水平的画风训练,LyCORIS 值得尝试。

🎉 好,把他们上市!

恭喜,你的丹炼好了!(也可能炼炸了)

在结束前,还是说一下一个不可避免的问题:

如果你用非常小的数据集训练(比如只有 1 张图),会遇到 “风格烘焙(Style Bake-In)” 的情况。

意思是你的 LoRA 不仅学会角色,还会深度吸收原画师的风格。

我个人不介意——我训练的主要是碧蓝航线的丹,很喜欢那种画师风格,所以乐意保留。

但如果你希望模型更通用(能跨多种风格使用),唯一的办法就是建立更大的数据集。

不过,总的来说,即便只有 1 张图,也完全可以训练 LoRA。难度确实更高,但只要有耐心,依然可行。

,1girl,chibi,portrait,;p,ahoge,cat ears,white hair,simple background,v,.jpeg)